Distribuições normal, chi-quadrado e F

Propriedades de variáveis aleatórias

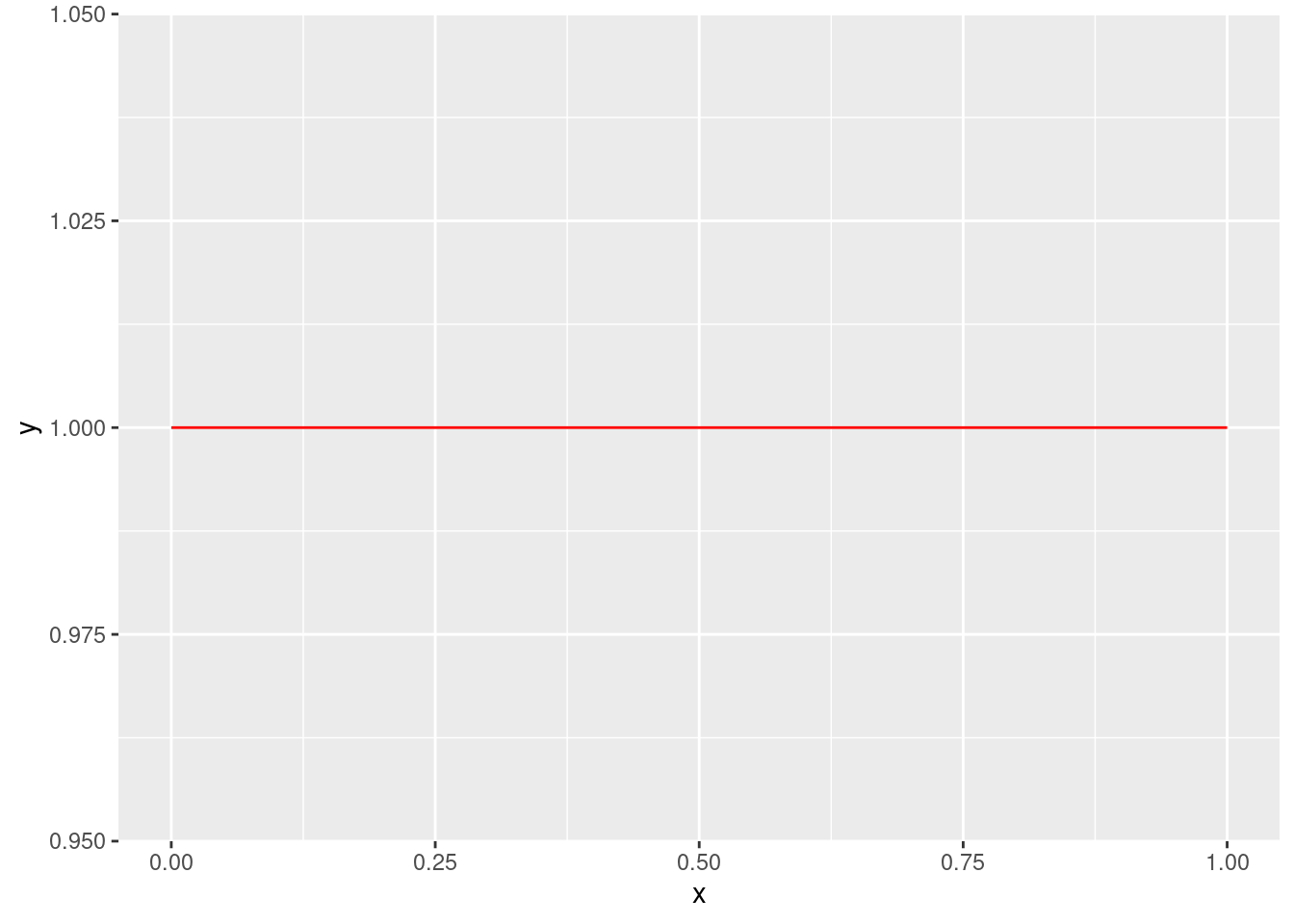

Uma forma de descrever a incerteza em relação

a uma variável aleatória é por meio de sua

função de densidade.

Se

library(tidyverse)

ggplot(data.frame(x = c(0, 1)), aes(x)) +

stat_function(fun = dunif, colour = "red", n = 100)

Uma propriedade importante de uma função de densidade é que

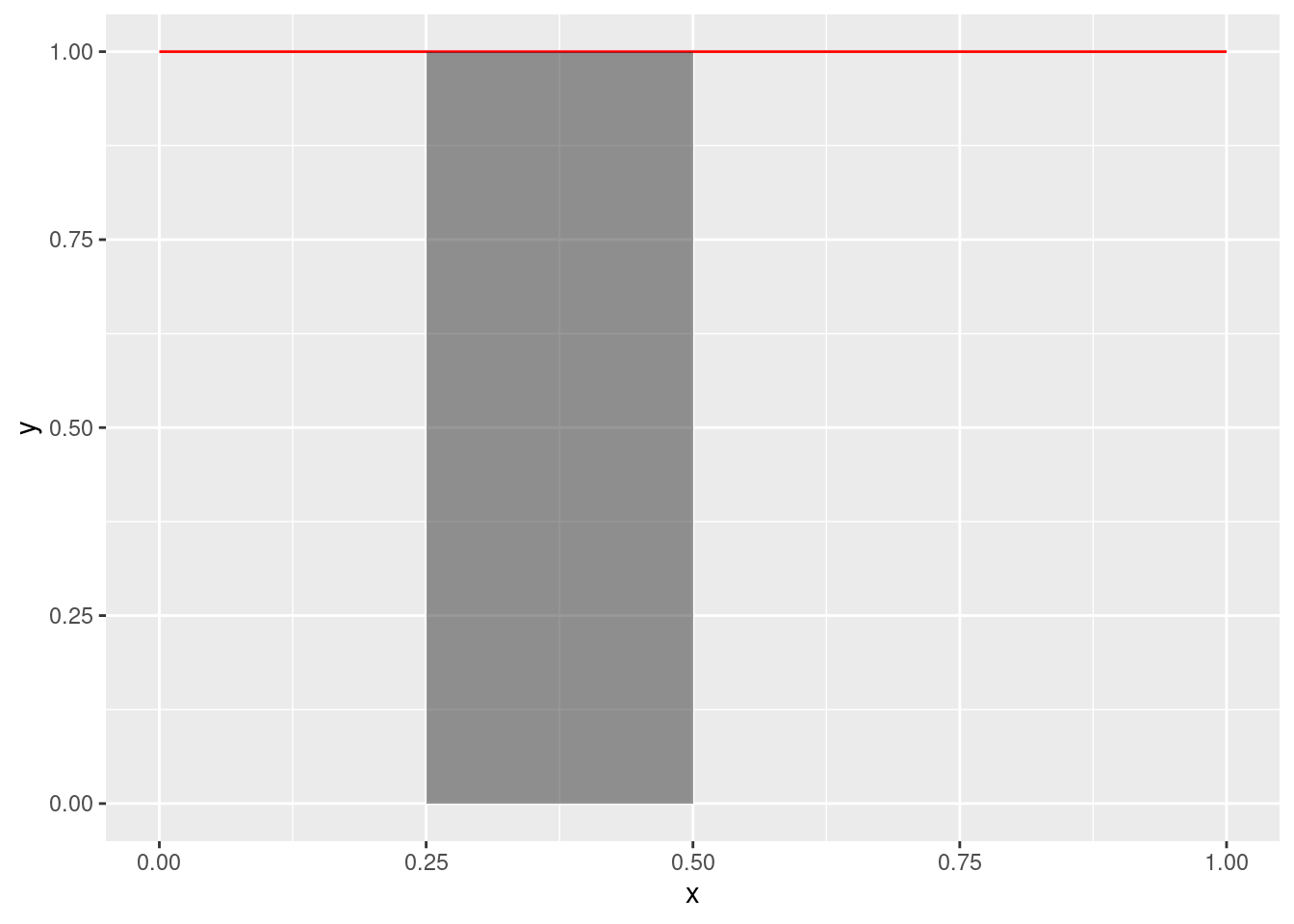

podemos obter a probabilidade de que

ggplot(data.frame(x = c(0, 1)), aes(x)) +

stat_function(fun = dunif, colour = "red", n = 100) +

stat_function(fun = dunif, xlim = c(0.25, 0.5), geom = "area", alpha = 0.5)

De forma geral, a área debaixo de uma curva é

dada por uma integral.

Neste curso não usaremos esta relação,

mas é útil saber que,

se

Também note que a área entre

A função de densidade descreve toda a incerteza sobre uma variável aleatória. Contudo, pode ser difícil descrever e analisar uma função. Assim, é comum que certos aspectos de uma variável aleatória sejam resumidos em números. A seguir, estudamos algumas destas medidas resumo.

Esperança (média populacional): A esperança de uma varíavel aleatória,

Variância (populacional): A variância de uma variável aleatória,

A seguir, estudaremos algumas funções de densidade essenciais para este curso.

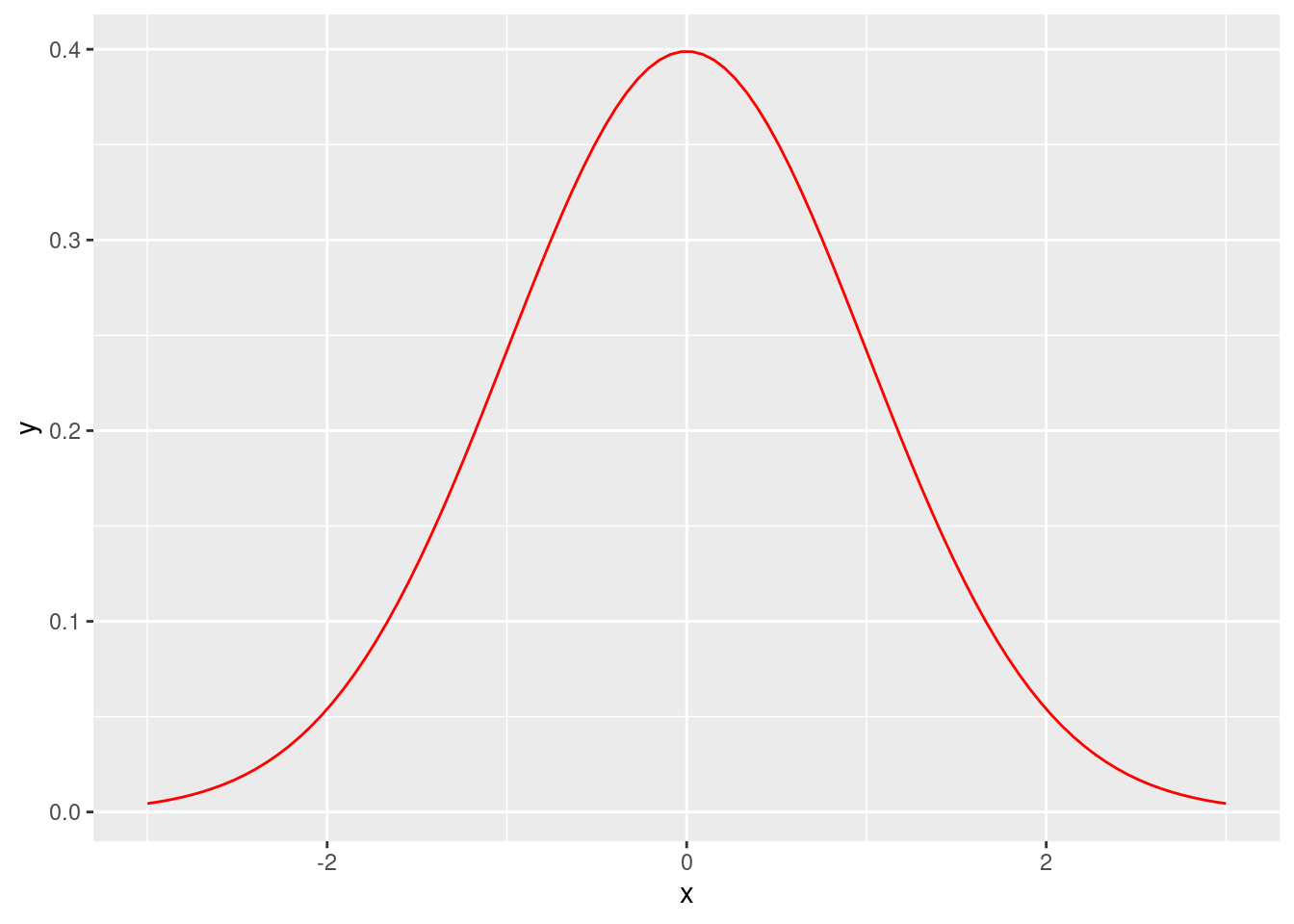

Distribuição normal

Uma das distribuições mais usadas é a Normal.

Formalmente, dizemos que

ggplot(data.frame(x = c(-3, 3)), aes(x)) +

stat_function(fun = dnorm, colour="red", n = 100)

Note que a densidade tem um formato de sino com

simetria ao redor do

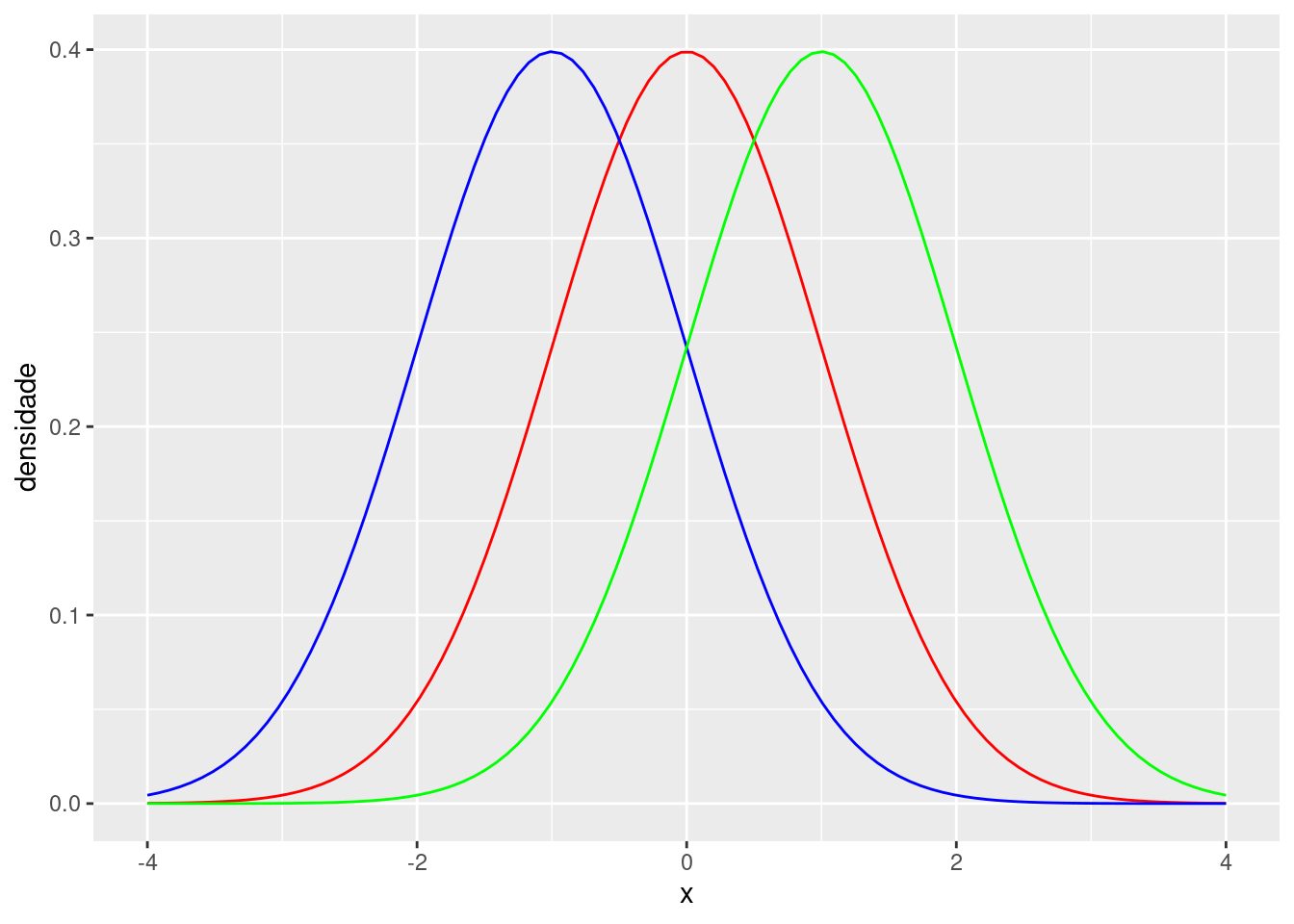

ggplot(data.frame(x = c(-4,4)), aes(x)) +

stat_function(fun = dnorm, colour = "red", n = 100) +

stat_function(fun = function(x) dnorm(x, mean = -1),

colour = "blue", n = 100) +

stat_function(fun = function(x) dnorm(x, mean = 1),

colour = "green", n = 100) +

ylab("densidade")

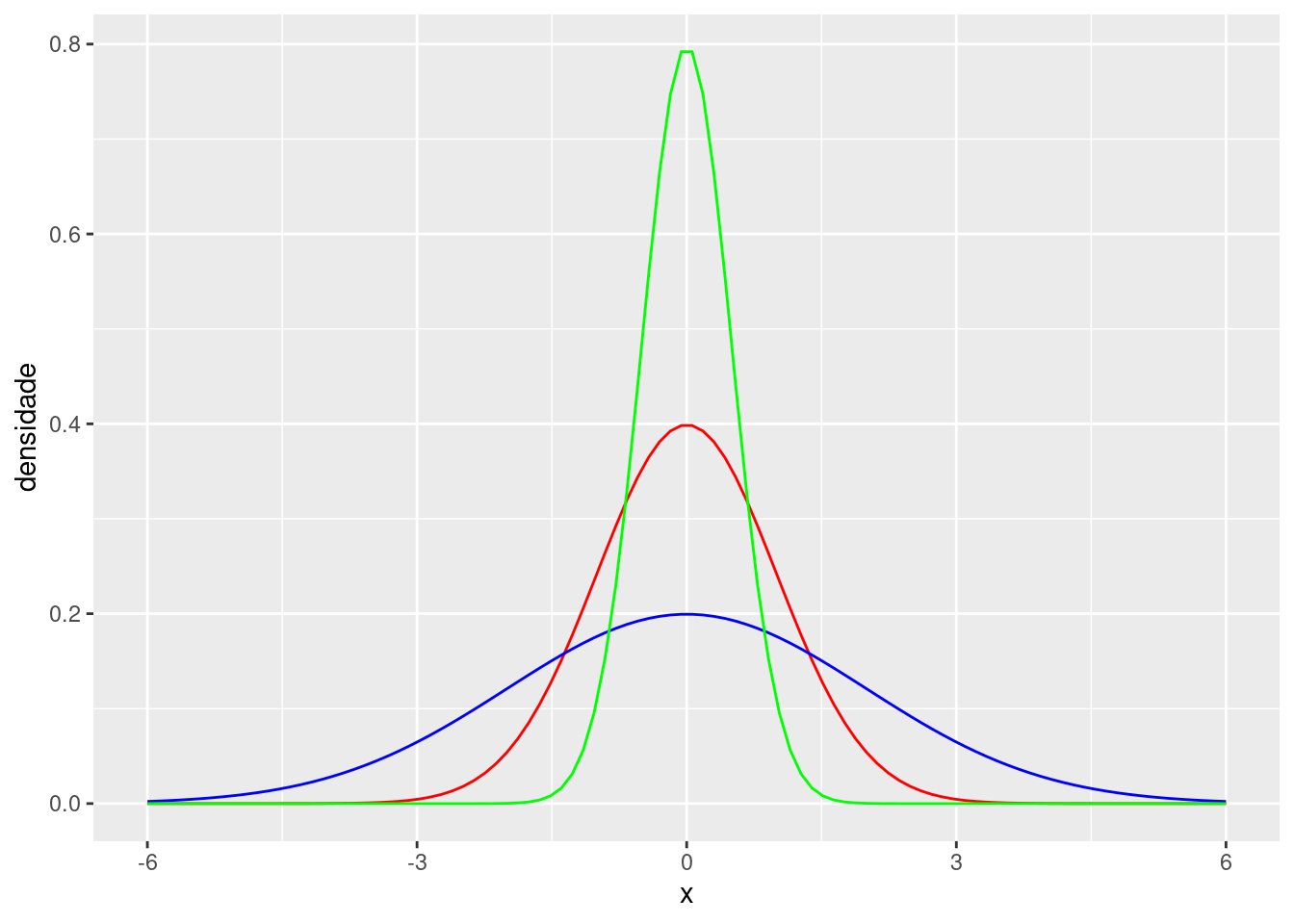

Semelhantemente, a figura abaixo apresenta

nas curvas verde, vermelha e azul, respectivamente,

as distribuições

ggplot(data.frame(x = c(-6,6)), aes(x)) +

stat_function(fun = dnorm, colour = "red", n = 100) +

stat_function(fun = function(x) dnorm(x, sd = 2),

colour = "blue", n = 100) +

stat_function(fun = function(x) dnorm(x, sd = 0.5),

colour = "green", n = 100) +

ylab("densidade")

Uma relação útil é que aproximadamente 95% da

densidade de uma

Se

pnorm(4, mean = 2, sd = 3)## [1] 0.7475075Também a probabilidade de que

uma

pnorm(4, mean = 2, sd = 3) - pnorm(1, mean = 2, sd = 3)## [1] 0.3780661É possível transformar qualquer distribuição normal

em uma normal padrão por meio de transformações lineares.

Especificamente, se

Teorema Central do Limite

O Teorema Central do Limite é

um dos resultados mais importantes em Estatística e

também uma das razões pelas quais

a distribuição é tão importante neste curso.

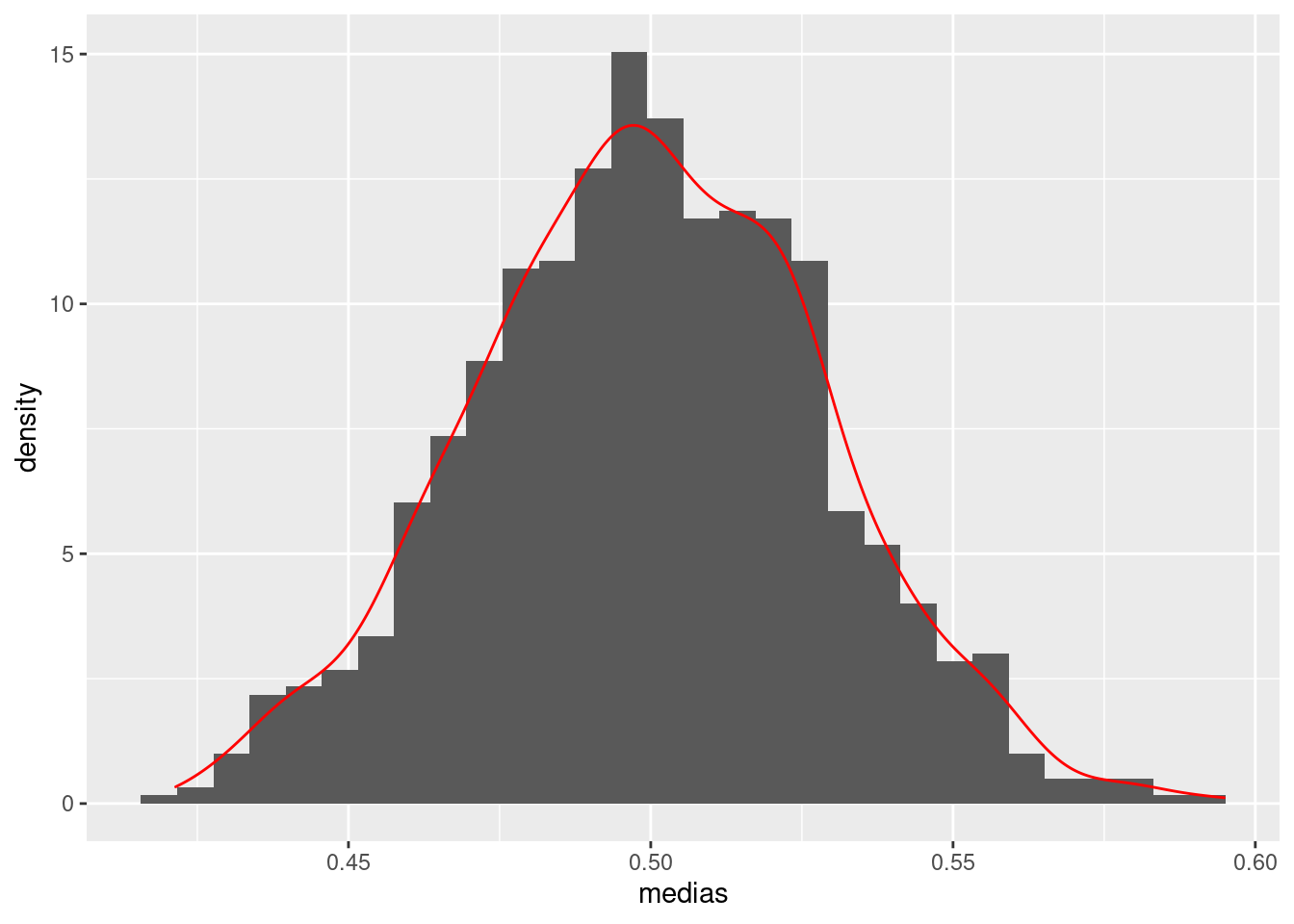

De forma suscinta, ele dita que, se

medias = rep(NA, 1000)

for(ii in 1:1000)

{

medias[ii] = mean(runif(100, 0, 1))

}

ggplot(aes(x = medias), data = data.frame(medias)) +

geom_histogram(aes(y = ..density..)) +

geom_density(colour="red")

Distribuição chi-quadrado

Se

Se

Se

Se

No R, podemos obter a densidade e

Distribui??o T de Student

Designamos a distribui??o

Se

No R, podemos obter a densidade e

Distribuição F de Snedcor

Se

- No R, podemos obter

a densidade e

Exercícios

Se

Se

Calcule a esperança e a variância de uma variável aleatória com distribuição uniforme entre

Ache um intervalo tal que uma

Se

Se

Se

Um pesquisador utilizou uma mesma medida resumo em diversas variáveis de seu banco de dados. Para visualizar estas medidas, construiu um histograma delas. Este histograma se encontra abaixo. Com base no histograma, argumente se a medida resumo poderia ou não ser a média amostral.